Google AdWords bietet ein bzw. zwei neue Features: Kampagnenentwürfe und –tests:

- Kampagnenentwürfe sind Duplikate bestehender Kampagnen, aus denen heraus keine Anzeigenschaltung stattfindet. Sie sind aktuell nur für die Typen „nur Suchnetzwerk“ und „Suchnetzwerk mit Displayauswahl“ verfügbar. An einem Entwurf können Sie Bearbeitungen vornehmen, um ihn dann entweder direkt auf die ursprüngliche Kampagne anzuwenden oder als Grundlage für einen Kampagnentest zu nehmen.

- Kampagnentests prüfen als Split-Tests, wie der Entwurf gegen die ursprüngliche Kampagne abschneidet. Sie sind neben dem alteingesessenen (ACE-)Test-Tool nunmehr ein zweites Tool innerhalb des AdWords-Kontos, um A/B-Tests im Konto durchzuführen.

Kampagnenentwurf anlegen

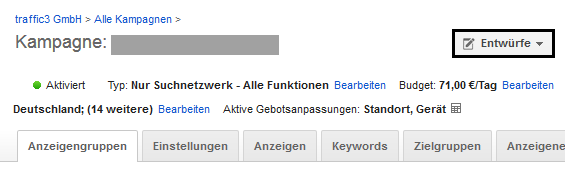

Für Kampagnenentwürfe öffnen Sie eine Ihrer vorhandenen Kampagnen und klicken auf den entsprechenden Button (Abbildung 01).

Abb.01: Entwurf eröffnen

Im Folgefenster geben Sie dem Entwurf einen eindeutigen Namen, so dass Sie später und auch bei mehreren Entwürfen wissen, was hier genau geändert wurde. Sobald Sie den Namen abgespeichert haben, landen Sie im Bereich „alle Entwürfe“, den Sie auch unterhalb der linken Baum-Navigation erreichen. Alle Elemente einer Kampagne sind hier für Sie erreichbar und, wie in einer ganz normalen Kampagne auch, änderbar: von den Kampagneneinstellungen über die Anzeigengruppenebene bis hin zu Keywords, Anzeigen und Anzeigenerweiterungen. In Abbildung 02 wird etwa der Bietpreis für alle Keywords um 50 Prozent angehoben.

Abb.02: Entwurf erstellen

Einige Funktionen sind bei Entwürfen jedoch nicht verfügbar. Zum einen sind dies natürlich Berichte, die Leistungsdaten benötigen. Diese liegen nicht vor, da Entwürfe ja nicht ausgespielt werden: etwa Dimensionen, Suchbegriffe, Auktionsdaten, Werbezeitplaner, die Keyword-Diagnose oder Berichte zu Display-Placements.

Zum anderen sind dies Tools wie das (ACE-)Test-Tool, Anzeigenanpassungen mit »Zielkampagne« oder »Zielanzeigengruppe« (etwa bei Echtzeit-Updates) sowie einige Gebotsstrategien (Klicks maximieren, Ausrichtung auf Seitenposition, kompetitive Auktionsposition und Ziel-ROAS). Diese Tools werden auch bei den Kampagnentests nicht unterstützt; Berichtsabfragen sind während und nach der Ausspielung hingegen voll verfügbar.

Bei den Änderungen sollten Sie von vornherein beachten, was Sie mit dem Entwurf anfangen wollen. Sie haben zwei Möglichkeiten (plus die Option, den Entwurf zu verwerfen – was beim Erstellen des Entwurfes aber sicherlich nicht Ihr primäres Ziel sein dürfte):

Erstens können Sie den Entwurf und somit alle durchgeführten Änderungen direkt auf eine Kampagne anwenden. Dies macht insbesondere Sinn, wenn Sie Änderungen, die Sie heute durchführen, zu einem späteren Zeitpunkt einspielen wollen: etwa weil Sie die Anpassungen freigegeben lassen müssen oder weil Sie noch weitere Einstellungen vornehmen wollen.

Zweitens können Sie den Entwurf als Testvariante für einen Test verwenden, bei dem die ursprüngliche, derzeit aktive Kampagne die Controlvariante ist. Da das Testverfahren ein A/B- oder Split-Test ist, sollten Sie nur eine Änderung vornehmen: Ansonsten ist es Ihnen nicht möglich, die Ergebnisse eindeutig zuzuordnen.

Ein Beispiel: Sie ändern in einer Kampagne sowohl die Gebote als auch die Zielseite, auf der die User geführt werden. Liefert der Test eine Verbesserung der Conversion-Rate, so können Sie nicht eindeutig bestimmen, ob dies nun auf die Bietpreise oder auf die Landingpage zurückzuführen ist.

Bei A/B-Tests gehen Sie idealerweise in einzelnen Schritten voran: Sie testen zwei Varianten genau eines Elements und können die Auswirkungen dann genau dieser Maßnahme zuordnen. Testen Sie hingegen ein ganzes Bündel an Maßnahmen bis hin zu einer komplett anderen Kampagne, so können Sie nur feststellen, dass das eine Bündel besser als das andere funktioniert. Welche Einzelmaßnahme dafür verantwortlich ist, ob es die Kombination macht oder ob ein Elemente des Gesamtpaketes gar negative Einflüsse hat, welche aber durch die positiven kompensiert werden - das wissen Sie nicht.

Haben Sie Ihre Änderungen durchgeführt, so klicken Sie im Entwurf auf den blauen Button „Anwenden“ und wählen im folgenden Layer eine der beiden eben besprochenen Anwendungsfälle aus.

Test erstellen

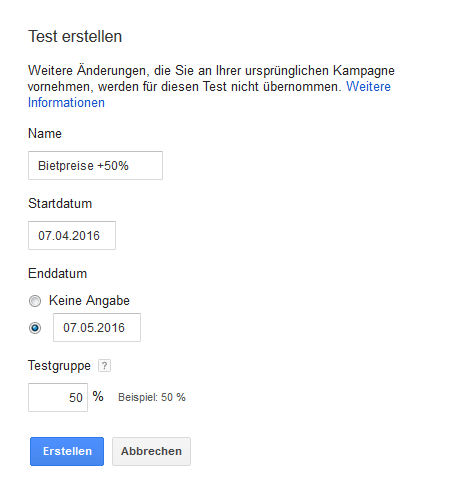

Wählen Sie die Option „Test erstellen“, so gelangen Sie auf einen Eingabelayer, der folgende Eingaben verlangt (siehe Abbildung 03):

- einen eindeutigen Namen für den Test.

- ein Start- und Enddatum. Letzteres gibt standardmäßig einen Monat Laufzeit vor.

- den Prozentsatz, zu dem die Testgruppe ausgespielt werden soll. Mit ihm geben Sie somit an, in welchem Verhältnis Kontroll- und Testgruppe, also ursprüngliche Kampagne und Kampagnenentwurf, bei passenden Suchanfragen aktiviert werden.

Abb.03: Test erstellen

Tests können jederzeit angehalten und auch verlängert werden. Stellen Sie das Enddatum daher nicht blindlings auf eine ferne Zukunft ein. Das Tool stoppt nicht automatisch, wenn valide Ergebnisse irgendeiner Art vorliegen. Überwachen Sie den Test nicht, so spielen Sie möglicherweise eine wenig erfolgreiche Testgruppe für lange Zeit aus. Dies kann sich empfindlich auf die Gesamtleistung Ihrer Kampagne auswirken.

Auch der Prozentsatz für die Testgruppe und damit die Verteilung zwischen Control und Test sollte gut überlegt sein. Hiermit steuern Sie, ob Sie den Test eher vorsichtig oder eher aggressiv angehen möchten – sicherlich auf Grundlage der Risiken und Erwartungen, aber auch auf Grundlage des Traffics. Denn Sie nehmen damit auch Einfluss auf die Länge des Tests.

- Lassen Sie beide Gruppen im Verhältnis 50:50 laufen, so nehmen bei 200 Auktionen 100 Mal die Kontroll-, 100 Mal die Testgruppe per Zufallsprinzip teil. Diese Aufteilung führt am schnellsten zu eindeutigen Ergebnissen.

- Geben Sie der Testgruppe nur 30%, so kommt es nur zu 60 Auktionsteilnahmen aus dieser Gruppe und 140 Auktionsteilnahmen aus der Kontrollgruppe. Hiermit wählen Sie zwar eine vorsichtigere Aufteilung, die das Risiko der neuen Einstellungen auf den Erfolg verringert. Doch läuft der Test in der Regel länger, bis er Ihnen valide Ergebnisse liefert.

Klicken Sie letztendlich auf den blauen Button „Erstellen“, so wird der Test von Google eingerichtet. Sobald dies abgeschlossen ist, startet er zum angegebenen Startdatum.

Test auswerten

Die Auswertungen erhalten Sie über den Link „alle Tests“ unterhalb der linken Baum-Navigation (siehe Abbildung 04). Durch Klick auf den entsprechenden Testnamen gelangen Sie zu den Auswertungen. Alternativ erreichen Sie diesen Bereich auch aus der ursprünglichen Kampagne heraus.

Abb.04: Kampagnentest auswerten

Die Testergebnisse finden Sie im blauen Headerbereich, aufrufbar für alle über die Baum-Navigation erreichbaren Ebenen: somit für Kampagnen und Anzeigengruppen. Beachten Sie, dass hier nur die Leistungsdaten für volle Tage innerhalb des abgefragten Zeitraums und innerhalb der Testlaufzeit angegeben werden. In untenstehender Tabelle finden Sie hingegen die Daten des gesamten abgefragten Zeitraums – also beispielsweise inklusive des ersten halben Tages, wenn Sie einen Test manuell zur Mittagszeit gestartet haben. Es kann somit zu Unterschieden kommen.

Die Validität der Ergebnisse wird wie gewohnt in Pfeilen angegeben:

- Das Maximum sind drei Pfeile. Diese bedeuten, dass nur noch eine Unsicherheit von 0,1% verbleibt.

- Bei zwei Pfeilen liegt die Wahrscheinlichkeit, dass die Unterschiede zufällig sind, bei einem Prozent.

- Ein Pfeil gibt an, dass die Zufälligkeit bei 5%, die Sicherheit also bei 95% liegt.

- Mit grauen Pfeilen sowohl nach oben als auch unten zeigt Google neutrale Ergebnisse an – es liegen also noch keine statistisch signifikanten Abweichungen zwischen Kontrolle und Test vor.

Ebenfalls im blauen Bereich oberhalb der Testdaten greifen Sie manuell auf den Test ein. Laufzeitänderungen nehmen Sie über „Bearbeiten“ hinter Start- und Enddatum vor. Liefert die Testvariante valide schlechtere Ergebnisse als die ursprüngliche Kampagne, so stoppen Sie den Test einfach über den Link „Jetzt beenden“. Ihre Kampagne läuft mit den bisherigen Einstellungen weiter.

Bringt die Testversion bessere Ergebnisse, so gelangen Sie über den Button „Anwenden“ zu zwei Optionen:

- Sie wenden die Änderungen auf die ursprüngliche Kampagne an oder

- Sie aktivieren die Testversion als neue Kampagne und pausieren die alte.

Wählen Sie die zweite Möglichkeit, so stehen Ihnen in der neuen Kampagne selbstverständlich keine Leistungsdaten aus der nunmehr pausierten Kampagne zur Verfügung. Falls Sie alte Daten benötigen, so müssen Sie also in der alten Kampagne nachschauen. Möchten Sie die Einstellungen der alten Kampagne doch noch auf irgendeine Weise nutzen, so wählen Sie hingegen die erste Option.

Abgesehen vom Headerbereich trennen Kampagnentests die während des Testzeitraums erzielten Ergebnisse konsequent für Kontroll- und Testgruppe. So zeigt Ihnen die Tabelle unter „alle Tests“ ausschließlich die Daten der Testvariante. Für Leistungsdaten der ursprünglichen Kampagne müssen Sie in die reguläre Konto-Statistik der ursprünglichen Kampagne wechseln. Sie befürchten zu Recht: Dies erschwert Vergleiche für alle weitergehende Daten, die Ihnen Google im Headerbereich nicht freiwillig zur Verfügung stellt. Trotz dieser Trennung werden in der Testgruppe anfallende Kosten natürlich ganz normal verrechnet.

Stärken und Schwächen der Kampagnentests

Die Art der Auswertung zeigt die Einschränkungen, die das neue Test-Tool mit sich bringt – auch im Gegensatz zum älteren (ACE-)Test-Tool: Auswertungen sind nicht auf Keyword- oder Anzeigenebene möglich. Es werden immer nur die Gesamtdaten zu allen aufgelisteten Elementen erfasst – was wiederum bei (ACE-)Test-Tool nicht möglich ist.

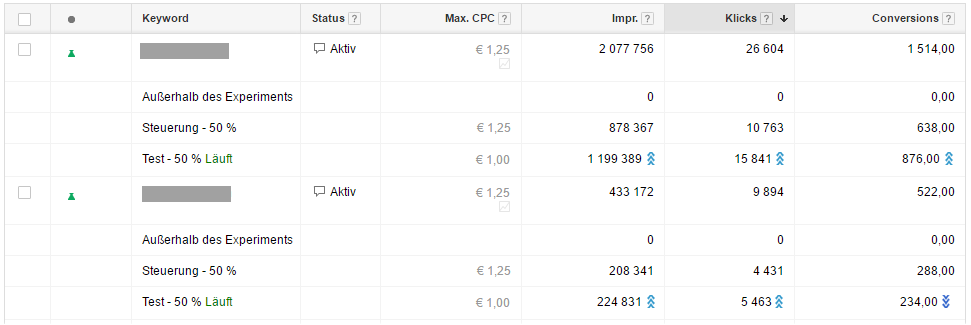

Dass Sie keine Daten auf Anzeigen- bzw. Keywordebene erhgalten, ist insofern mehr als unpassend, als Optimierungen genau dort, also auf den niedrigsten Ebenen, ansetzen sollten. Die Abbildungen 05 und 06 verdeutlichen das Problem anhand eines (ACE-) Tests, bei dem als Control ein niedrigerer Bietpreis eingestellt wurde. Gemäß Abbildung 05 liefert der Split-Test auf Anzeigengruppenebene valide Steigerungen bezüglich Conversions – wonach somit die Gebotssenkung übernommen werden sollte.

Abb.05: Testergebnisse – Anzeigengruppenebene

In Abbildung 06 sehen Sie nun exemplarisch zwei Keywords aus dieser Anzeigengruppe: Keyword Eins bestätigt das Ergebnis auf Anzeigengruppenebene. Keyword Zwei weist hingegen eine valide Verschlechterung der Conversions auf und sollte daher mit dem alten Gebot eingestellt bleiben. Bekommen Sie im ACE-Test-Tool diese Daten geliefert, so müssen Sie sie bei Kampagnentests manuell vergleichen und errechnen.

Abb.06: Testergebnisse - Keywordebene

Die strikte Trennung von Test- und Controldaten zeigt sich auch in der Konto-Statistik Ihrer ursprünglichen Kampagne. Dort werden die gesamten Testergebnisse in einer zusätzlichen Zeile „Gesamt – alle Tests“ dargestellt.

Als Vorteil der Kampagnentests bleibt insbesondere festzuhalten, dass nun auch Kampagneneinstellungen getestet werden können. Dies ist mit dem ACE-Test-Tool, selbst als Einstellung positioniert, nicht möglich. So können Sie nun etwa unterschiedliche Budgets, Werbezeiten oder Gebotsstrategien testen. Bei Letzteren werden wiederum nur die Strategien manuell, Ziel-CPA und auto-optimierter CPC unterstützt.

Neben dem Testen von Kampagneneinstellungen machen natürlich auch die Klassiker weiterhin Sinn: etwa eine feinere Anzeigengruppenstruktur, erweiterte oder gekürzte Keywordlisten, Umstellen von Keywordoptionen, CPC-Tests auf Keyword- oder Anzeigengruppenebene sowie Anzeigentests.

Wollen Sie nacheinander mehrere Änderungen testen, so können Sie in einem Schwung bis zu fünf Kampagnentests anlegen. Ausgeführt wird jedoch immer nur einer. Die Menge der änderbaren Elemente ist unbegrenzt.

Handling und Datenverwaltung sind bei den Kampagnentests zumindest teilweise besser als beim (ACE-)Test-Tool gelöst: Das Anlegen der Testkampagne erfolgt wie das Anlegen einer jeden üblichen Kampagne und sollte somit vertraut sein. Die Aufbereitung der verfügbaren Auswertungen bringt auch Verbesserungen: Alle vergangenen und laufenden Tests finden Sie gesammelt im Bereich »alle Tests«. Leistungsdaten bleiben Ihnen auch nach Testende erhalten.

Da die Testvariante wie eine selbständige Kampagne angezeigt wird, sind zudem weitere Auswertungen genau dafür möglich. Dies reicht von der Angabe der dortigen Qualitätsfaktoren bis hin zu Abfragen wie etwa Dimensionen, Suchbegriffe oder Segmente. Als Einschränkung bleibt, dass der Vergleich zur ursprünglichen Kampagnen umständlich bleibt und nur über ein zweites Browserfenster vorgenommen werden kann.

Fazit

Wie so häufig weist auch das neue Tool-Duo Stärken und Schwächen auf. Die Möglichkeit, Kampagnenentwürfe anlegen zu können, ist sicherlich zu begrüßen. Ebenso macht es Freude, nun auch Kampagneneinstellungen testen zu können. Als Nachteil bleibt jedoch festzuhalten, dass Änderungen auf Keyword- und Anzeigenebene nicht ausgewiesen werden, sondern selbständig errechnet werden müssen.

Mit nur einem Keyword pro Anzeigengruppe hat sich das Problem selbstredend erledigt, denn auf Anzeigengruppenebene erhalten Sie Auswertungen. Für spezielle Situationen und entsprechend wichtige und häufig gesuchte Keywords kann dies durchaus eine Lösung sein.

In allen anderen Fällen müssen Sie die Validität für die Keywords und Anzeigen selbst errechnen – also sowohl die Daten zur Testvariante als auch zur ursprünglichen Kampagne aufrufen und dann außerhalb des Kontos abgleichen. Dies kann ein durchaus aufwendiger Schritt sein, der Ihnen im ACE-Test-Tool aufgrund der anderen Ergebnisdarstellung erspart bleibt. In der Praxis ist das Problem dann theoretischer Natur, wenn ihre einzelnen Keywords aufgrund ungenügenden Traffics in vernünftigen Testzeiträumen sowieso zu keinen validen Ergebnissen kommen – und Sie daher für Optimierungen auf die übergeordnete Anzeigengruppenebene ausweichen müssen.

Mit nunmehr zwei Test-Tools bleibt natürlich trotzdem festzuhalten: Beide bieten großartige Möglichkeiten, Entscheidungen auf Grundlage von echten Ergebnissen, nicht auf Grundlage von Vermutungen und Hoffnungen zu treffen. Für die Zukunft gilt daher mehr als je zuvor: Optimieren durch ständiges (Split-)Testen.